Playgrounds IA 2025

Una manera rápida de probar modelos sin mancharse las manos

En este terreno todavía joven de la IA generativa, los conceptos y definiciones a veces resultan difusos. Para entendernos, llamaremos “Playground de IA” a un entorno —generalmente accesible desde la web— con una interfaz sencilla que permite experimentar con diferentes modelos de manera rápida, sin necesidad de programar ni montar una infraestructura técnica compleja.

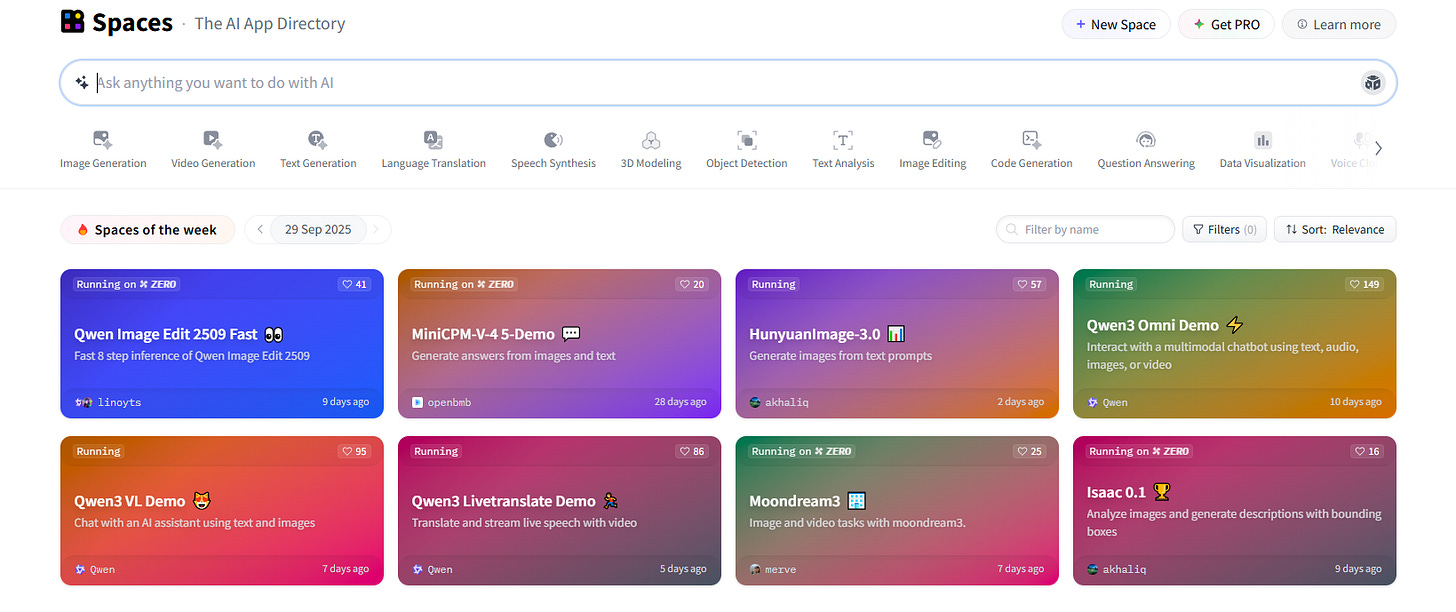

El primero del que quiero hablaros es HuggingFace, concretamente de su sección Spaces.

Pero antes, una breve introducción.

Cualquiera que haya trasteado un poco con IA seguramente se ha cruzado ya con Hugging Face. Es una plataforma colaborativa y de código abierto que funciona como un gran repositorio de modelos preentrenados. Allí no solo puedes acceder a infinidad de modelos, sino también crear y entrenar los tuyos propios (con herramientas como Transformers o AutoTrain). Todo ello bajo la filosofía de código abierto que hace que experimentar con IA esté al alcance de prácticamente cualquiera.

En la parte de Spaces puedes elegir qué modelo quieres probar y acceder directamente a un entorno de uso, donde es posible ajustar parámetros básicos e incluso algunos más avanzados.

Eso sí: conviene tener en cuenta que la mayoría de los modelos disponibles son open source o de libre acceso. Esto significa que quizá no encuentres determinados modelos comerciales o cerrados, salvo que sus creadores los hayan compartido en la plataforma.

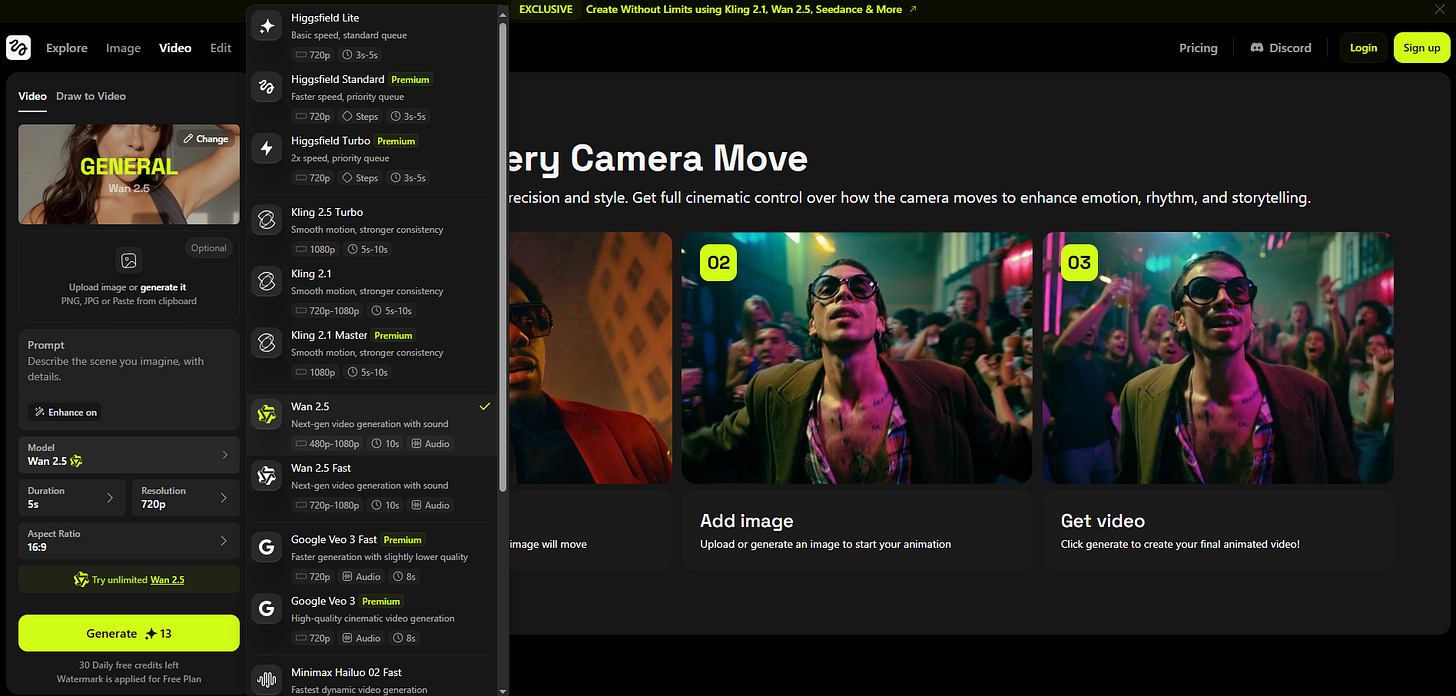

La siguiente plataforma de la que quiero hablaros es Higgsfield.ai

A diferencia de Hugging Face, aquí ya hablamos de una plataforma de pago que ofrece acceso a algunos de los modelos más potentes del momento, como Veo 3, Kling 2.5, Wan 2.5 o Seedance Pro. La gran ventaja es que no necesitas registrarte en la web de cada desarrollador: todo está integrado en un único entorno.

El sistema funciona con créditos, que se van descontando en cada generación que hagas. Puede parecer un detalle menor, pero a mí me resulta bastante práctico, sobre todo para comparar modelos antes de decidir en qué dirección avanzar.

Por ejemplo: puedes subir la misma imagen, aplicar el mismo prompt en modo image-to-video y ver cómo responde cada modelo. La diferencia de resultados suele ser reveladora, y en minutos entiendes cuál se ajusta mejor a lo que buscas.

Podríamos seguir hablando de muchos otros playgrounds sencillos de este estilo, así que aquí os dejo una pequeña lista para que podáis experimentar por vuestra cuenta:

Freepik, Runway, Midjourney, NVIDA´s Ai playground, Open Ai Playground…

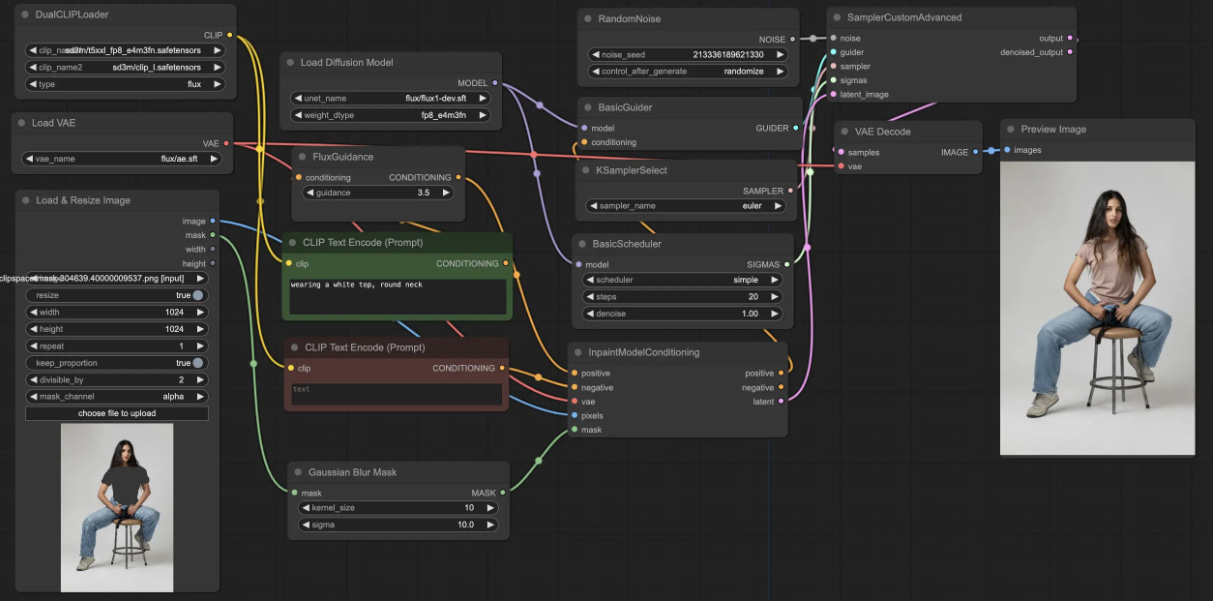

Pero llegados a este punto quiero detenerme en el que, personalmente, es mi favorito: ComfyUI.

A diferencia de los playgrounds clásicos, que suelen ser simples cuadros de texto, ComfyUI funciona con un sistema de nodos: cada nodo representa una parte del proceso (modelo, prompt, sampler, imagen, etc.), y al conectarlos construyes un workflow visual que define cómo se genera la imagen.

Lo que realmente me atrae de ComfyUI es la enorme cantidad de elementos de control y personalización que ofrece, y que fuera de este entorno suelen estar ausentes o muy limitados. En el mundo de los VFX, añadir esta capa de control no es un extra, es imprescindible: solo así puedes acercarte a resultados concretos y relativamente previsibles..

LoRAs, ControlNets, IP-Adapters, embeddings… son algunos de esos elementos de control de los que iremos hablando en próximos posts, y que convierten a ComfyUI en el entorno más adecuado para trabajar con la IA de una forma verdaderamente creativa y dirigida.

En los próximos posts iremos desgranando cómo funcionan estos elementos dentro de ComfyUI y qué posibilidades reales abren para artistas y creadores.

Seguimos explorando.

Lo bueno empieza ahora🚀